Apple のニュースが満載の新しい 1 週間が終わりました。今日は回復の日ですが、過去 7 日間を振り返る日でもあります。必ずしも毎日朝から晩まで私たちを読む時間がない人もいるかもしれません。そのため、その期間で最も読まれた記事について言及した前週の要約から大きな利益を得ることができます。

これがまさに私たちがここで提供するものです。今週の見逃せない記事はこちらです。iPhon.fr で読んだり、再読したりしてください。i-info.frアプリ内、もちろんコメントすることもできます。

過去 7 日間の必見の iPhon.fr

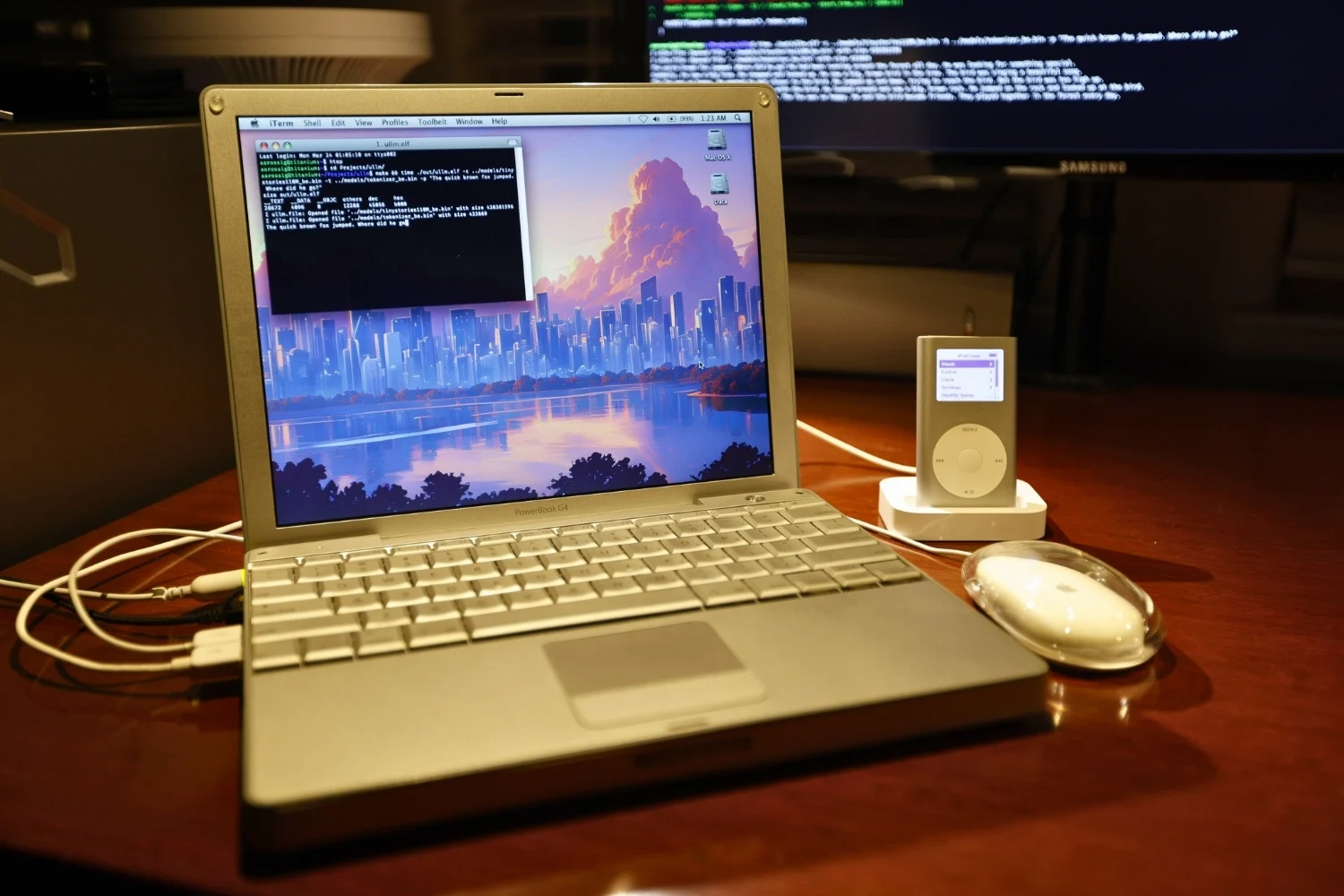

- 1月23日:Apple は古い Mac と iPhone を大切に扱います

- 1月23日:アップルリング:リンゴにつながったリングがテーブルに戻る

- 1月24日:iOS 17.4は特にヨーロッパで待望されています

- 1月24日:AirPods で新しいアップデートが利用可能です。インストール方法は次のとおりです。

- 1月26日:iOS 17.4 のベータ 1: いくつかの歴史的な機能を含むすべての新機能

特記事項シックス・ネーションズ・トーナメントの試合をフォローするためのアプリのセレクション。

その他の最近のニュース、さらに詳しく

ソースはほとんどの場合英語です。

- CarPlay から Soundcloud が到着 (ソース)

- iPhone の Photon Camera 2.0 アプリのアップデート (ソース)

- モルガン・スタンレーはウォール街のAAPLに大きく賭けている(ソース)

- 雑誌は Apple を 2024 年の最高のブランドの 1 つとしてランク付けしています (ソース)

- Shazam がついにワイヤレスヘッドフォンで動作します (ソース)

- TikTok は 30 分のビデオに移行しています (ソース)

- Brave の人工知能のアップデート (ソース)

- SimpleX Chat 5.5 は新機能を歓迎します (ソース)

- Day One は引き続き Journal (ソース)

- Netflixは無料提供を中止したいと考えています(ソース)

- Appleはロシアで高額の罰金を支払わなければならなかった(ソース)

- iPhoneは中国でナンバーワンです(ソース)

- Apple は従業員 1 人当たり数百万ドルの収益を上げています (ソース)

- ザ識別キーによってサポートされていますソース)

- Mac 上の Google Chrome 用の生成人工知能 (ソース)

- Galaxy S24: 電話機の True Tone の代替品 (ソース)

- Google Chromeのプライベートブラウジングは役に立たないのでしょうか? (ソース)

最後に、お見逃しなく前週の要約。

i-nfo.fr - 公式 iPhon.fr アプリ

提供者: Keleops AG